您现在的位置:首页 --> 查看专题: Spark

Facebook 经常使用数据驱动的分析方法来做决策。在过去的几年,用户和产品的增长已经需要我们的分析工程师一次查询就要操作数十 TB 大小的数据集。我们的一些批量分析执行在古老的 Hive 平台( Apache Hive 由 Facebook 贡献于 2009 年)和 Corona 上——这是我们定制的 MapReduce 实现。Facebook 还不断增加其对 Presto 的用量,用于对几个包括 Hive 在内的内部数据存储的 ANSI-SQL 查询。我们也支持其他分析类型,比如图数据库处理(graph processing)和机器学习(Apache Giraph)和流(例如:Puma、Swift 和 Stylus)。

下面这些关于Spark的性能调优项,有的是来自官方的,有的是来自别的的工程师,有的则是我自己总结的。

Data Serialization,默认使用的是Java Serialization,这个程序员最熟悉,但是性能、空间表现都比较差。还有一个选项是Kryo Serialization,更快,压缩率也更高,但是并非支持任意类的序列化。

Memory Tuning,Java对象会占用原始数据2~5倍甚至更多的空间。最好的检测对象内存消耗的办法就是创建RDD,然后放到cache里面去,然后在UI上面看storage的变化;当然也可以使用SizeEstimator来估算。使用-XX:+UseCompressedOops选项可以压缩指针(8字节变成4字节)。在调用collect等等API的时候也要小心——大块数据往内存拷贝的时候心里要清楚。

本文将教大家怎样用10个步骤完成给Apache Spark贡献代码这个任务:)

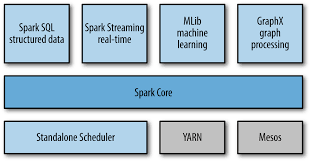

Spark是UC Berkeley AMP lab所开源的类Hadoop MapReduce的通用的并行计算框架,Spark基于map reduce算法实现的分布式计算,拥有Hadoop MapReduce所具有的优点;但不同于MapReduce的是Job中间输出和结果可以保存在内存中,从而不再需要读写HDFS,因此Spark能更好地适用于数据挖掘与机器学习等需要迭代的map reduce的算法。

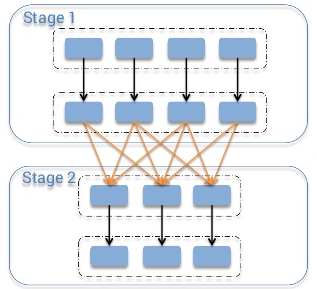

希望能够给希望尝试Spark的朋友,带来一些帮助。目前的版本是0.5.0 Spark开发指南 从高的层面来看,其实每一个Spark的应用,都是一个Driver类,通过运行用户定义的main函数,在集群上执行各种并发操作和计算 Spark提供的最主要的抽象,是一个弹性分布式数据集(RDD),它是一种特殊集合,可以分布在集群的节点上,以函数式编程操作集合的方式,进行各种各样的并发操作。它可以由hdfs上的一个文件创建而来,或者是Driver程序中,从一个已经存在的集合转换而来。用户可以将数据集缓存在内存中,让它被有效的重用,进行并发操作。最后,分布式数据集可以自动的从结点失败中恢复,再次进行计算。

[ 共6篇文章 ][ 第1页/共1页 ][ 1 ]

近3天十大热文

-

[1347] WordPress插件开发 -- 在插件使用

[1347] WordPress插件开发 -- 在插件使用 -

[125] IOS安全–浅谈关于IOS加固的几种方法

[125] IOS安全–浅谈关于IOS加固的几种方法 -

[78] Python 代码规范小结

[78] Python 代码规范小结 -

[60] 海量小文件存储

[60] 海量小文件存储 -

[57] 微博架构与平台安全演讲稿

[57] 微博架构与平台安全演讲稿 -

[57] 15个最好的免费开源电子商务平台

[57] 15个最好的免费开源电子商务平台 -

[53] 也谈谈前端,架构,框架与库

[53] 也谈谈前端,架构,框架与库 -

[52] 过年回家有感:他们的互联网

[52] 过年回家有感:他们的互联网 -

[47] 姐要的视频广告

[47] 姐要的视频广告 -

[40] 使用Squid缓存视频

[40] 使用Squid缓存视频

赞助商广告