您现在的位置:首页 --> 查看专题: 抓取

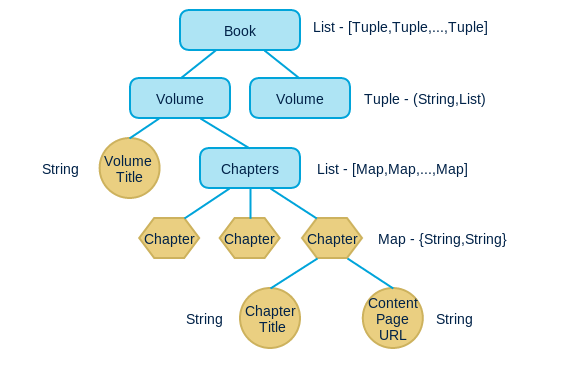

自从买了kindle后,总是想着如何最大效用发挥其效用。虽然多看上有很多书可以购买,网上也有很多免费的电子书,但是仍然有很多感兴趣的内容是以网页的形式存在的。例如O’Reilly Atlas就提供了诸多电子书,但是只提供免费的在线阅读;另外还有很多资料或文档都只有网页形式。于是就希望通过某种方法讲这些在线资料转为epub或mobi格式,以便在kindle上阅读。这篇文章介绍了如何借助calibre并编写少量代码来达到这个目的。

很多社区论坛或者博客在初期上线时候会遇到没有内容的尴尬,索性他们就会去把别人的优质的内容整理放到自己的平台上,这个时候就会请技术人员写采集程序程序来完成这件事情,以前我在一家公司做产品,同事说做一个可以换点米,所以就写了好几个,后来没有了消息,想程序放着也放着,不如拿出来分享,下载地址:sina blog 采集程序 ,这是借用专业采集类snoopy写的,因为很多博客会禁止采集,所以用snoopy伪装客户端很方便。 数据采集过来要交给编辑去整理发布,采集这么多的数据如何做好分类就是一件很有意义的事情了,编辑可以用这些内容分类汇总,把没有价值的内容去掉,所以数据仅仅采集过来是不够的,接下来就会涉及到数据的分类汇总,对内容进行过滤识别。

定向抓取有很多的应用场景,比如B2C商品的抓取,点评的抓取等等。在本文提到的系统里面,主要使用linux+mysql+redis+django+scrapy+webkit,其中scrapy+webkit作为抓取端,redis作为链接库存储,mysql作为网页信息存储,django作为爬虫管理界面,快速实现分布式抓取系统的原型。

网络爬虫(web crawler)又称为网络蜘蛛(web spider)是一段计算机程序,它从互联网上按照一定的逻辑和算法抓取和下载互联网的网页,是搜索引擎的一个重要组成部分。一般的爬虫从一部分start url开始,按照一定的策略开始爬取,爬取到的新的url在放入到爬取队列之中,然后进行新一轮的爬取,直到抓取完毕为止。 我们看一下crawler一般会遇到什么样的问题吧: 抓取的网页量很大 网页更新量也很大,一般的网站,比如新闻,电子商务网...

cURL 是一个支持包括HTTP、FTP、TELNET等多种协议使用URL语法规定来传输文件和数据的工具。令人高兴的是,cURL(supported by PHP)被PHP支持。下面将介绍一些在PHP中使用cURL的方法。为什么要使用cURL $content = file_get_contents("http://www.biaodianfu.com"); // or $content = file("http://www.biaodianfu.com"); // or $content = readfile("http...

Hyer是我个人用来抓取站点内容的一个工具包。后来慢慢地想做成一个开源软件,现在它注册在http://www.github.com/xurenlu/hyer/ 上。本文作为入门教程,以新华网作为例子,讲讲如何用hyer做网页抓取。请从这里http://github.com/xurenlu/hyer/downloads下载hyer-0.6.12.tar.gz这个压缩包,解压。我们要用的主要是webctl.py这个文件,我们需要对它进行一些修改。在修改之前,先创建一个数据库,将sql/struct.sql导入进去。 mysql&#...

[ 共7篇文章 ][ 第1页/共1页 ][ 1 ]

近3天十大热文

-

[783] WordPress插件开发 -- 在插件使用

[783] WordPress插件开发 -- 在插件使用 -

[61] Java将Object对象转换为String

[61] Java将Object对象转换为String -

[61] cookie窃取和session劫持

[61] cookie窃取和session劫持 -

[58] 学习:一个并发的Cache

[58] 学习:一个并发的Cache -

[57] 你必须了解的Session的本质

[57] 你必须了解的Session的本质 -

[52] Linux如何统计进程的CPU利用率

[52] Linux如何统计进程的CPU利用率 -

[52] 再谈“我是怎么招聘程序员的”

[52] 再谈“我是怎么招聘程序员的” -

[51] 最萌域名.cat背后的故事:加泰与西班牙政府

[51] 最萌域名.cat背后的故事:加泰与西班牙政府 -

[50] 解读iPhone平台的一些优秀设计思路

[50] 解读iPhone平台的一些优秀设计思路 -

[49] 豆瓣是啥?

[49] 豆瓣是啥?

赞助商广告