关于流量升高导致TIME_WAIT增加,MySQL连接大量失败的问题

搜索有个应用就是每次都会去查一个接口,接口返回用户的信息数据,从而展现不同的筛选和排序效果。大致流程如下

s.taobao.com(hz)-> memcache ->电信custom接口 ->master-db

s.taobao.com(qd)-> 网通custom接口 -> slave-db

接口环境是php(cgi) + nginx,接口已经运行很久,未出过异常

搜索访问custom接口,然后接口去查数据库(数据库是主从复制,数据同步,各自机房读各自的数据库,写的话都写master-db)

有一点,就是电信机房是有memcache层的,而网通机房一直没有(考虑到网通机房流量不高,并且机房cache不同步,从上线起就网通机房一直未使用cache)

有一次搜索上线,这个上线的版本有个改动就是把电信机房的memcache也取消了,然后 电信机房流量暴增

看pv统计:

[admin@linux ~]$ xxx.sh “find ./ -name ‘access*’|xargs wc -l|awk ‘END{print$1}’” fe

cmd :find ./ -name ‘access*’|xargs wc -l|awk ‘END{print }’

type:fe

server1

27720029 total(28号是11428684total)

———-

server2

27719910 total(28号是11429158total)

———-

server3

21084539 总计

———-

server4

21086051 total

网通机房流量一直都是2KW左右,从未出任何问题

就是昨天电信custom接口流量暴增后,出现了异常,电信机房机器负载一度达到48左右,QPS达到1533,直到凌晨0:24分才降到1以下

应用也报了短暂的超时警报,不过php和nginx运行还是比较蛋定,重启依然非常快,终端也没有出现很卡的情况

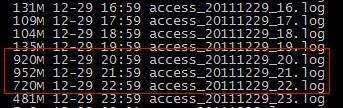

29号流量:

28号流量:

异常就是error.log在上线后飙到3个G!!!

而且错误全都是Can’t connect to MySQL server on ’1.1.1.1′ (99)

即便在命令行下用mysql -h1.1.1.1 -u -p

也间歇性地连接不上,但是据dba描述,数据库监控无任何异常,数据库上其他部门的应用也无异常

不知是否机器负载过高导致大量time wait,导致mysql连接超时或连接不上

以下是晚上0点13分的监控:

80端口连接数(CurrentConnection): 16

nginx进程数量: 10

php进程数量: 130

TCP连接状态:

TIME_WAIT 26258(不知是否和他有关)

FIN_WAIT1 1

FIN_WAIT2 6

ESTABLISHED 893

按理说,custom的网通接口流量一直是日均2KW,从未出现过异常,杭州机房接口飙到2.7KW就抗不住了,load直线上升,

为了排除cache引起的流量导致接口异常,22:30左右重新上了2个文件,把杭州机房的memcache重新开启,

开启后慢慢load是降了,但是mysql错误依旧只是没那么多了

现在去机器上看,还是大量错误,提取日志如下

2011/12/3010:23:58 [error] 23859#0: *19554416 FastCGI sent in stderr: “PHPWarning: mysql_connect() [

后来跟dba不断沟通排查,发现电信机房和网通机房的/etc/sysctl.conf配置有所区别

网通机房多了下面几行

net.ipv4.tcp_syncookies =1

net.ipv4.tcp_tw_reuse = 1

net.ipv4.tcp_tw_recycle =1

net.ipv4.tcp_fin_timeout= 5

原因就在这,把配置同步到杭州机房后,问题就解决了,总结如下:

net.ipv4.tcp_tw_recycle = 1

net.ipv4.tcp_fin_timeout = 5

// 让参数生效

/sbin/sysctl -p

建议继续学习:

- Linux下三种常用的流量监控软件对比 (阅读:9782)

- 脚本利用SNMP mib/oid分析网卡流量 (阅读:7662)

- nicstat 网络流量统计利器 (阅读:7199)

- cacti+apache+php+mysql+rrdtool搭建流量监控平台 (阅读:6568)

- 通过shell 脚本查看服务器的时时流量 (阅读:4811)

- 网络流量监控软件vnStat (阅读:4657)

- 你的服务器能承受多大流量 (阅读:4341)

- 再叙TIME_WAIT (阅读:4126)

- linux单机根据ip查看流量 (阅读:4078)

- 在CGI中通过Etag和Cache-Control来控制流量,访问量及生效时间 (阅读:4046)

扫一扫订阅我的微信号:IT技术博客大学习

- 作者:桃子 来源: 搜索技术博客-淘宝

- 标签: TIME_WAIT 流量 连接

- 发布时间:2012-05-10 23:36:01

-

[1190] WordPress插件开发 -- 在插件使用

[1190] WordPress插件开发 -- 在插件使用 -

[81] 解决 nginx 反向代理网页首尾出现神秘字

[81] 解决 nginx 反向代理网页首尾出现神秘字 -

[43] web开发设计人员不可不用的在线web工具和

[43] web开发设计人员不可不用的在线web工具和 -

[36] Java开发岗位面试题归类汇总

[36] Java开发岗位面试题归类汇总 -

[30] Rax 系列教程(长列表)

[30] Rax 系列教程(长列表) -

[30] 手机产品设计方向

[30] 手机产品设计方向 -

[29] 一句话crontab实现防ssh暴力破解

[29] 一句话crontab实现防ssh暴力破解 -

[27] 程序员疫苗:代码注入

[27] 程序员疫苗:代码注入 -

[27] 如何建立合适的索引?

[27] 如何建立合适的索引? -

[25] oracle技术方面的路线

[25] oracle技术方面的路线